En Windows Server 2012 se introdujo el nuevo feature llamado “Data Deduplication” que nos permite básicamente realizar la eliminación de datos duplicados.

En Windows Server 2012 se introdujo el nuevo feature llamado “Data Deduplication” que nos permite básicamente realizar la eliminación de datos duplicados.

La deduplicación de datos es una técnica especializada de compresión de datos para eliminar copias duplicadas de datos repetidos. Un término relacionado con la deduplicación de datos es la compresión inteligente de datos. Esta técnica se usa para optimizar el almacenamiento de datos en disco y también para reducir la cantidad de información que debe enviarse de un dispositivo a otro a través de redes de comunicación.

Esta características que se convirtió rápidamente en una de las cosas normales a considerar al implementar servidores de archivos, ya que nos brinda más espacio en el hardware existente, sin costo alguno; solo debemos tener Windows Server 2012.

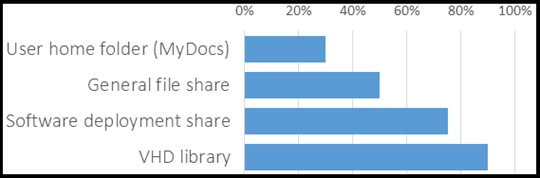

Con esta característica, hemos visto grandes ahorros de espacio en varios tipos de datos del mundo real en reposo. Algunos de los tipos más comunes de datos incluyen:

Estas cifras se basan en la medición de las tasas de ahorro en diversas implementaciones de los clientes de eliminación de datos duplicados en Windows Server 2012. Sin embargo, hemos visto algunas tendencias interesantes:

-

Los clientes estaban ajustando las políticas predeterminadas para los archivos que desean optimizar para incluir más datos. Por defecto, la deduplicación de datos sólo optimiza los archivos que no han sido modificados en 5 días. Los clientes estaban preparando para optimizar los archivos mayores de 3 días y en muchos casos para optimizar todos los archivos independientemente de su edad.

-

Los clientes estaban tratando de optimizar sus bibliotecas VHD… que por supuesto no terminaba funcionando correctamente

En ambos casos vemos que la gente trata de poner más datos dentro de la deduplicación de datos y para un mejor aprovechamiento de los enormes ahorros se ven en las bibliotecas estáticas VHD. Sin embargo, la deduplicación de datos en Windows Server 2012 no estaba diseñada para hacer frente a los datos que cambian con frecuencia o incluso está en uso activo.

El camino a nuevas cargas de trabajo para la Eliminación de datos duplicados

Segun el feedback de los clientes que se nos ofrecía mostró una clara necesidad de reducir los gastos de almacenamiento en nubes privadas; para una visión general de todas las demás cosas nuevas alrededor de almacenamiento) y, específicamente, para extender la deduplicación de datos para las nuevas cargas de trabajo.

Específicamente teníamos que empezar a soportar el almacenamiento de los discos duros virtuales en vivo para algunos escenarios.

Resulta que había algunos cambios clave que había que hacer para siquiera considerar el uso de la deduplicación de datos para archivos abiertos:

-

El rendimiento de lectura era bastante bueno ya, pero el rendimiento de escritura necesita ser mejorado.

-

La velocidad a la que la deduplicación de datos optimiza los archivos necesarios para ser más rápido para mantenerse al día con los cambios (churn) en archivos.

-

Se ha tenido que permitir que los archivos abiertos para optimizar mediante la deduplicación de datos (si bien de forma activa estaba siendo modificado)

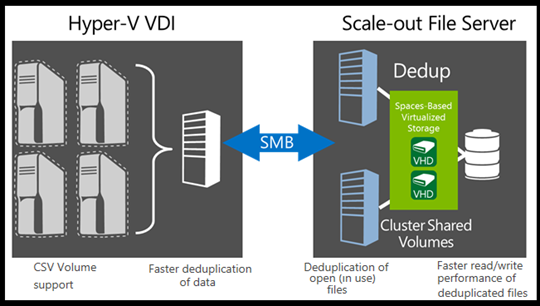

También, que todas estas modificaciones tenían un impacto directo sobre los recursos del servidor que ejecuta la deduplicación de datos. Si vamos a ejecutar esto en el mismo servidor que las máquinas virtuales, el HOST, entonces estaríamos compitiendo con ellos por los recursos. Especialmente la memoria. Así que rápidamente se llegó a la conclusión de que era necesario separar los nodos de almacenamiento y de cálculo cuando la deduplicación de datos esta involucrada con la virtualización. Por supuesto esto significo que se realizara un análisis de los shares y que se soportaran volúmenes CSV para la eliminación de datos duplicados.

Sin embargo, sabemos que la deduplicación de datos tiene que incurrir en algunos gastos. Así que se necesitaba objetivos reales. Resulta que decidiendo que son lo suficientemente rápidos como para todos los escenarios de virtualización es muy difícil. Así que se decidió dar un primer paso con una carga de trabajo de virtualización que se entiende bien:

La deduplicación de datos en Windows Server 2012 R2 soporta la optimización de almacenamiento para infraestructura en implementaciones de escritorio virtual (VDI), siempre y cuando los nodos de almacenamiento y cómputo se conectan de forma remota.

¿Qué hay de nuevo en la eliminación de datos duplicados en Windows Server 2012 R2

Con Windows Server 2012 R2, la deduplicación de datos se extiende al almacenamiento remoto de la carga de trabajo VDI:

Esta Hyper-V soportada con un volumen deduplicados?

Se ha invertido un montón de tiempo para asegurar que la deduplicación de datos funcione correctamente en las cargas de trabajo generales de virtualización. Sin embargo, nos se han centrado los esfuerzos para asegurar que el rendimiento de los archivos optimizados es adecuado para escenarios de VDI. Para los escenarios no VDI (VMs Hyper-V en general), no se ofrecen las mismas garantías de rendimiento.

Como resultado, no se soporta la deduplicación arbitraria en el uso de discos duros virtuales VHDs en Windows Server 2012 R2. Sin embargo, dado que la deduplicación de datos es una parte fundamental de la pila de almacenamiento, no hay ningún bloque explícita en el lugar que le impide ser habilitado en las cargas de trabajo arbitrarios.

¿Qué beneficios que obtenemos de deduplicación de datos utilizando la norma VDI?

Vamos a empezar con la más fácil: ahorraremos espacio! Y, por supuesto, el ahorro de espacio se traduce en ahorro de dinero. Las tasas de eliminación de datos duplicados para los despliegues en VDI pueden ir tan alto como 95% de ahorro. Esto permite que las implementaciones de volúmenes basados en SSD para VDI, aprovechen todas las características mejoradas IO al tiempo que mitiga su baja capacidad. Esto también permite la simplificación de la infraestructura que rodea tales como JBOD, refrigeración, electricidad, etc.

Por otra parte, debido al hecho de que Eliminación de datos duplicados consolida los archivos, los mecanismos de almacenamiento en caché más eficientes son posibles. Esto da como resultado en la mejora de las características IO del subsistema de almacenamiento para algunos tipos de operaciones. Así que no sólo la deduplicación a ahorrar dinero, puede hacer que las cosas van más rápido. Como resultado de estos, a menudo podemos estirar la capacidad de VM del subsistema de almacenamiento sin necesidad de comprar hardware o infraestructura adicional.

Wrap-up

La deduplicación de datos en Windows Server 2012 R2 permite la optimización de los discos duros virtuales en vivo para las cargas de trabajo VDI y permite volúmenes CSV deduplicados. También mejora significativamente el rendimiento de la optimización, así como IO en archivos optimizados. Esto permitirá una mejor utilización de los subsistemas de almacenamiento existentes para servidores de archivos generales, así como para el almacenamiento de VDI y simplificar las futuras inversiones en infraestructuras.

Espero que les sea de interes. Saludos. Roberto Di Lello.

[…] Windows Server 2012 R2: Extendiendo “Data Deduplication” a nuevos workloads […]